- Nvidia stellte am Montag die H200 vor, eine GPU, die zum Trainieren und Bereitstellen der Arten von KI-Modellen entwickelt wurde, die den generativen KI-Boom antreiben.

- Der H200 verfügt über 141 GB „HBM3“-Speicher der nächsten Generation, der ihm bei der Generierung von Texten, Bildern oder Vorhersagen mithilfe von KI-Modellen hilft.

- Das Interesse an Nvidias KI-gestützten GPUs hat die Dynamik des Unternehmens angekurbelt, wobei der Umsatz in diesem Quartal voraussichtlich um 170 % steigen wird.

Jensen Huang, Präsident von Nvidia, hält die Grace-Hopper-Chip-CPU, die in der generativen KI verwendet wird, bei der Keynote-Präsentation von Supermicro während der Computex 2023 in der Hand.

Walid Barazek | Rocket Lite | Getty Images

Nvidia stellte am Montag die H200 vor, eine GPU, die zum Trainieren und Bereitstellen der Arten von KI-Modellen entwickelt wurde, die den generativen KI-Boom antreiben.

Die neue GPU ist ein Upgrade des H100, dem Chip, den OpenAI zum Trainieren seines fortschrittlichsten großen Sprachmodells GPT-4 verwendet hat. Große Unternehmen, Startups und Regierungsbehörden konkurrieren um einen begrenzten Vorrat an Chips.

Raymond James schätzt, dass H100-Chips zwischen 25.000 und 40.000 US-Dollar kosten, und dass Tausende von ihnen benötigt werden, um in einem Prozess namens „Training“ zusammenzuarbeiten, um die größten Modelle zu erstellen.

Die Aufregung um Nvidias KI-gestützte GPUs hat die Aktien des Unternehmens in die Höhe getrieben, die im Jahr 2023 bisher um mehr als 230 % gestiegen sind. Nvidia erwartet für das dritte Geschäftsquartal einen Umsatz von rund 16 Milliarden US-Dollar, 170 % mehr als im Vorjahr.

Die wichtigste Verbesserung des H200 besteht darin, dass er über 141 GB „HBM3“-Speicher der nächsten Generation verfügt, der dem Chip dabei hilft, „Heuristiken“ durchzuführen oder ein großes Modell zu verwenden, nachdem es für die Generierung von Text, Bildern oder Vorhersagen trainiert wurde.

Nvidia sagte, dass der H200 eine Ausgabe fast doppelt so schnell erzeugen wird wie der H100. Dies basiert auf Tests mit Metas Llama 2 LLM.

Der H200, der voraussichtlich im zweiten Quartal 2024 ausgeliefert wird, wird mit der MI300X-GPU von AMD konkurrieren. Der AMD-Chip verfügt, ähnlich wie der H200, im Vergleich zu seinen Vorgängern über zusätzlichen Speicher, was dazu beiträgt, dass große Modelle auf der Hardware Platz finden, um Inferenzen auszuführen.

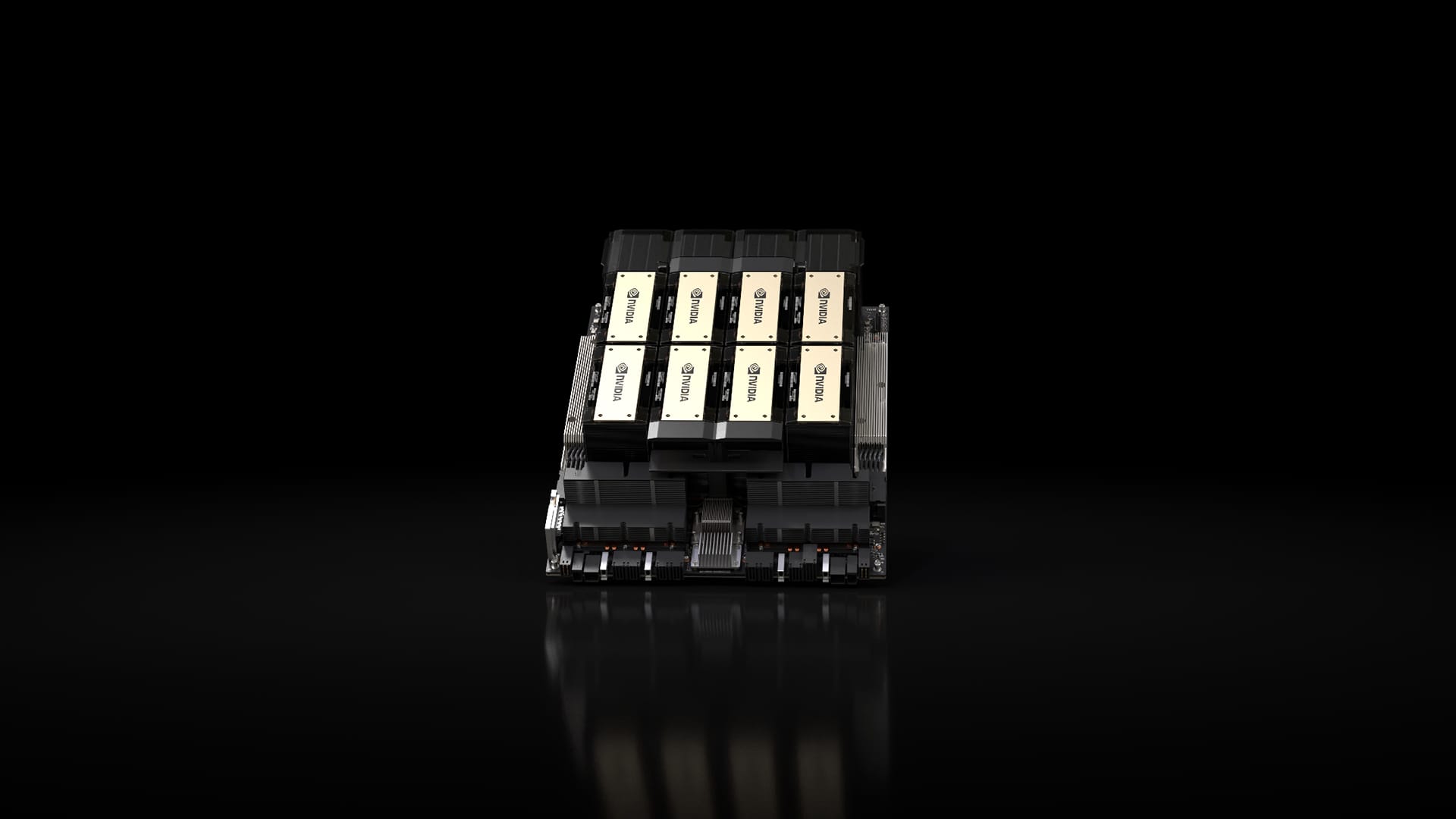

Nvidia H200-Chipsatz in einem Nvidia HGX-System mit acht GPUs.

Nvidia

Nvidia sagte, dass der H200 mit dem H100 kompatibel sein wird, was bedeutet, dass KI-Unternehmen, die bereits mit dem Vorgängermodell arbeiten, ihre Serversysteme oder Software nicht ändern müssen, um die neue Version zu verwenden.

Nvidia sagt, dass es in Serverkonfigurationen mit vier GPUs oder acht GPUs auf den vollständigen HGX-Systemen des Unternehmens sowie in einem Chip namens GH200 verfügbar sein wird, der die H200-GPU mit einem Arm-basierten Prozessor verbindet.

Allerdings wird der H200 möglicherweise nicht lange die Krone des schnellsten Nvidia-KI-Chips halten.

Während Unternehmen wie Nvidia viele verschiedene Konfigurationen ihrer Chips anbieten, machen neue Halbleiter oft etwa alle zwei Jahre einen großen Schritt nach vorne, wenn Hersteller auf eine andere Architektur umsteigen, die größere Leistungssteigerungen ermöglicht als das Hinzufügen von Speicher oder andere kleinere Verbesserungen. Der H100 und der H200 basieren auf der Hopper-Architektur von Nvidia.

Im Oktober teilte Nvidia den Investoren mit, dass es aufgrund der hohen Nachfrage nach seinen GPUs von einem zweijährigen Architekturrhythmus zu einem einjährigen Veröffentlichungsrhythmus übergehen werde. Das Unternehmen bot an Folie schlägt vor Es wird seinen B100-Chip, der auf der kommenden Blackwell-Architektur basiert, im Jahr 2024 ankündigen und veröffentlichen.

Er schaut: Wir glauben fest an den KI-Trend, der im nächsten Jahr Einzug halten wird

Verpassen Sie nicht diese Geschichten von CNBC PRO:

„Musikfan. Sehr bescheidener Entdecker. Analytiker. Reisefreak. Extremer Fernsehlehrer. Gamer.“

More Stories

Pershing Square, ein amerikanisches Unternehmen im Besitz des Milliardärs Bill Ackman, verschiebt seinen Börsengang

Das Kryptowährungsunternehmen Ledger erhöht den Preis der Stax-Kryptowährungsbrieftasche und führt Flex ein

Tesla-Aktien fielen im vorbörslichen Handel um 7 %, nachdem sie keinen Gewinn erwirtschafteten