Jensen Huang, CEO von Nvidia, hält eine Grundsatzrede während der Nvidia GTC AI-Konferenz im SAP Center am 18. März 2024 in San Jose, Kalifornien.

Justin Sullivan | Getty Images

Die neue Generation KI-gestützter Grafikprozessoren heißt Blackwell. Der erste Chip von Blackwell heißt GB200 und wird noch in diesem Jahr ausgeliefert. Nvidia lockt seine Kunden mit leistungsstärkeren Chips, um neue Bestellungen anzukurbeln. Beispielsweise ringen Unternehmen und Softwarehersteller immer noch um die Beschaffung von „Hopper“-H100-Chips und ähnlichen Chips der aktuellen Generation.

„Hopper ist großartig, aber wir brauchen größere GPUs“, sagte Nvidia-CEO Jensen Huang am Montag auf der Entwicklerkonferenz des Unternehmens in Kalifornien.

Nvidia-Aktien fielen im erweiterten Handel am Montag um mehr als 1 %.

Das Unternehmen führte außerdem ein umsatzgenerierendes Programm namens NIM ein, das den Einsatz von KI erleichtern und Kunden einen weiteren Grund geben wird, in einem wachsenden Wettbewerbsfeld weiterhin Nvidia-Chips zu verwenden.

Führungskräfte von Nvidia sagen, das Unternehmen sei weniger ein Söldner-Chipanbieter, sondern eher ein Plattformanbieter wie Microsoft oder Apple geworden, auf dem andere Unternehmen Software aufbauen können.

„Blackwell ist kein Chip, es ist der Name einer Plattform“, sagte Huang.

„Das kommerziell verkäufliche Produkt war die GPU und die Software sollte den Menschen helfen, die GPU auf unterschiedliche Weise zu nutzen“, sagte Manuvir Das, Vizepräsident der Nvidia Foundation, in einem Interview. „Natürlich machen wir das immer noch. Aber was sich wirklich geändert hat, ist, dass wir jetzt tatsächlich ein Unternehmen für Unternehmenssoftware haben.“

Das sagte, die neue Software von Nvidia werde es einfacher machen, Software auf allen GPUs von Nvidia auszuführen, auch auf älteren, die möglicherweise besser für die Bereitstellung, aber nicht für die Entwicklung von KI geeignet seien.

„Wenn Sie ein Entwickler sind und ein interessantes Modell haben, das die Leute übernehmen sollen, stellen wir sicher, dass es auf allen unseren GPUs spielbar ist, wenn Sie es in NIM einbinden, sodass Sie viele Leute erreichen können.“ Das sagte.

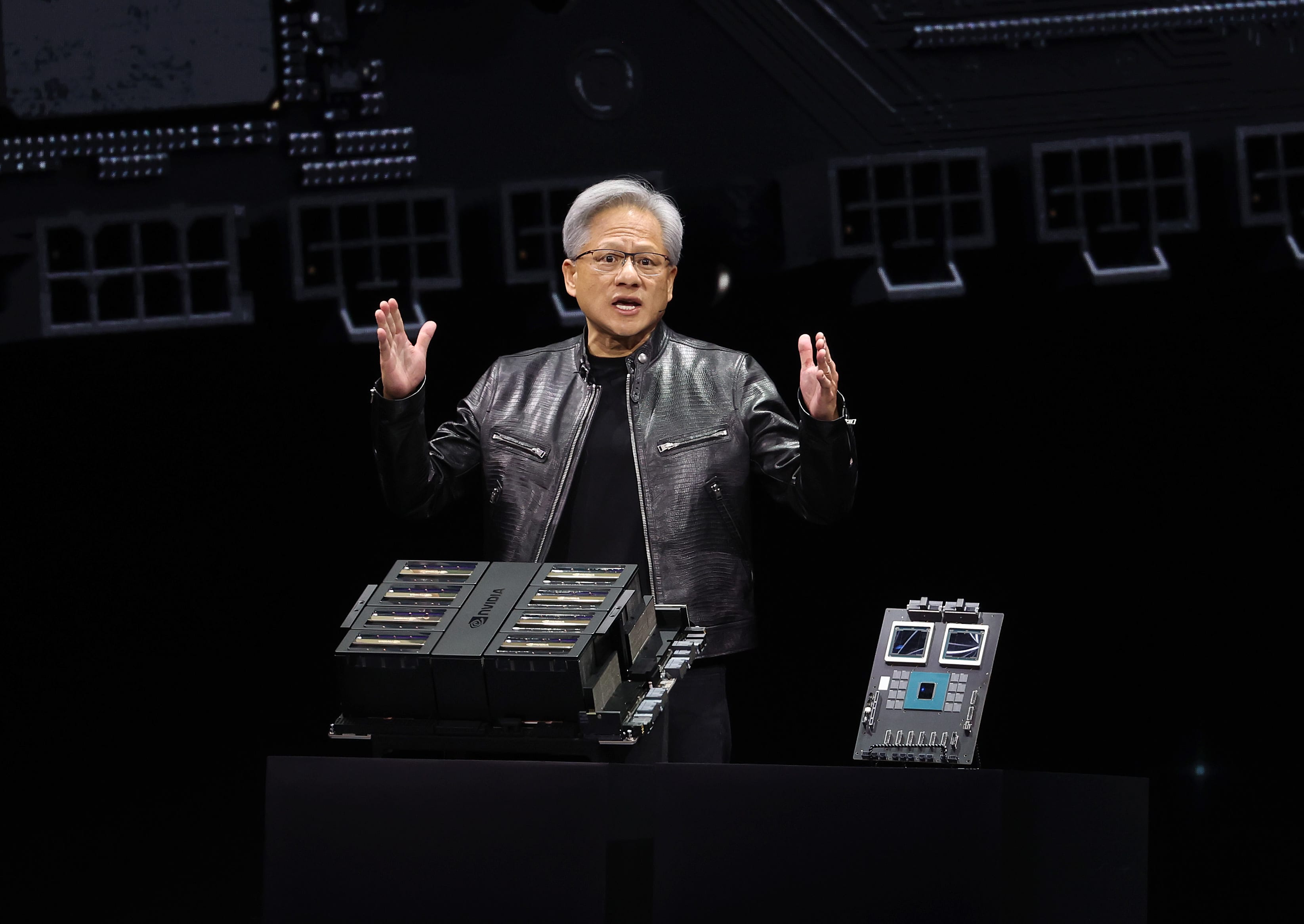

Nvidias GB200 Grace Blackwell Superchip mit zwei B200-GPUs und einer Arm-basierten CPU.

Alle paar Jahre aktualisiert Nvidia seine GPU-Architektur und ermöglicht so einen enormen Leistungssprung. Viele der im vergangenen Jahr veröffentlichten KI-Modelle wurden auf der Hopper-Architektur des Unternehmens trainiert – die Chips wie der H100 verwendet – die 2022 angekündigt wird.

Laut Nvidia bieten Blackwell-basierte Prozessoren wie der GB200 eine enorme Leistungssteigerung für KI-Unternehmen, mit 20 Petaflops in der KI-Leistung gegenüber 4 Petaflops beim H100. Nvidia sagte, die zusätzliche Rechenleistung werde es KI-Unternehmen ermöglichen, größere, komplexere Modelle zu trainieren.

Der Chip enthält das, was Nvidia eine „Transformer-Engine“ nennt, die speziell für die transformatorbasierte KI entwickelt wurde, eine der Kerntechnologien, die ChatGPT zugrunde liegen.

Die Blackwell-GPU ist groß und vereint zwei separat hergestellte Chips in einem einzigen Chip von TSMC. Es wird auch als Komplettserver namens GB200 NVLink 2 erhältlich sein, der 72 Blackwell-GPUs und andere Nvidia-Teile zum Trainieren von KI-Modellen kombiniert.

Nvidia-CEO Jensen Huang vergleicht auf der Entwicklerkonferenz des Unternehmens in San Jose, Kalifornien, die Größe des neuen „Blackwell“-Chips mit dem aktuellen „Hopper“-H100-Chip.

Nvidia

Amazon, Google, Microsoft und Oracle werden den Zugang zum GB200 über Cloud-Dienste verkaufen. Der GB200 kombiniert zwei B200-Blackwell-GPUs mit einer einzigen Arm-basierten Grace-CPU. Nvidia sagte, Amazon Web Services werde eine Serverfarm mit 20.000 GB200-Chips aufbauen.

Nvidia sagte, das System könne ein Modell mit 27 Billionen Parametern bereitstellen. Dies ist viel größer als selbst die größten Modelle wie GPT-4, das 1,7 Billionen Parameter enthalten soll. Viele KI-Forscher glauben, dass größere Modelle mehr Parameter und Daten enthalten Es kann neue Fähigkeiten freischalten.

Nvidia machte keine Angaben zu den Kosten für die neue GB200 oder die darin verwendeten Systeme. Nvidias Hopper-basierter H100 kostet laut Analystenschätzungen zwischen 25.000 und 40.000 US-Dollar pro Chip, komplette Systeme kosten bis zu 200.000 US-Dollar.

Nvidia wird die B200-GPUs auch als Teil eines Komplettsystems verkaufen, das ein ganzes Server-Rack einnimmt.

Nvidia gab außerdem bekannt, dass es seinem Nvidia Enterprise-Programmabonnement ein neues Produkt namens NIM hinzufügt, das für Nvidia Inference Microservice steht.

NIM erleichtert die Verwendung älterer Nvidia-GPUs für Inferenzen oder die Ausführung von KI-Programmen und ermöglicht es Unternehmen, weiterhin Hunderte Millionen Nvidia-GPUs zu verwenden, die sie bereits besitzen. Inferenz erfordert weniger Rechenleistung als das anfängliche Training eines neuen KI-Modells. NIM ermöglicht Unternehmen, die ihre eigenen KI-Modelle ausführen möchten, anstatt Zugang zu KI-Ergebnissen als Service von Unternehmen wie OpenAI zu erwerben.

Die Strategie besteht darin, Kunden, die Nvidia-basierte Server kaufen, dazu zu bringen, Nvidia Enterprise zu abonnieren, dessen Lizenzierung 4.500 US-Dollar pro GPU und Jahr kostet.

Nvidia wird mit KI-Unternehmen wie Microsoft oder Hugging Face zusammenarbeiten, um sicherzustellen, dass seine KI-Modelle so abgestimmt sind, dass sie auf allen kompatiblen Nvidia-Chips laufen. Mithilfe von NIM können Entwickler das Modell dann ohne langwierigen Konfigurationsprozess effizient auf ihren eigenen Servern oder den cloudbasierten Servern von Nvidia ausführen.

„In meinem Code, in dem ich OpenAI aufrief, würde ich eine Codezeile ersetzen, um sie auf das NIM zu verweisen, das ich stattdessen von Nvidia erhalten habe“, sagte Das.

Nvidia sagt, dass die Software auch dazu beitragen wird, dass KI auf Laptops mit GPU läuft, statt auf Servern in der Cloud.

„Musikfan. Sehr bescheidener Entdecker. Analytiker. Reisefreak. Extremer Fernsehlehrer. Gamer.“

More Stories

Die Aktien des Chipriesen für künstliche Intelligenz Nvidia gaben trotz seines Rekordumsatzes von 30 Milliarden US-Dollar nach

General Motors und Samsung einigen sich auf den Bau einer Batteriefabrik für Elektrofahrzeuge in Indiana im Wert von 3,5 Milliarden US-Dollar

Aktien steigen, während der Nvidia-Countdown beginnt: Markets Wrap