Es ist schwierig, mit einer schnelllebigen Branche wie der KI Schritt zu halten. Bis KI dies für Sie erledigen kann, finden Sie hier eine hilfreiche Zusammenfassung der neuesten Geschichten aus der Welt des maschinellen Lernens sowie bemerkenswerte Forschungsergebnisse und Experimente, die wir nicht selbst behandelt haben.

TechCrunch plant übrigens, am 5. Juni einen KI-Newsletter zu veröffentlichen. Folgen Sie uns ständig. In der Zwischenzeit erhöhen wir die Häufigkeit unserer halbregelmäßigen KI-Kolumne, die zuvor etwa zweimal im Monat erschien, auf wöchentlich – bleiben Sie also gespannt auf weitere Veröffentlichungen.

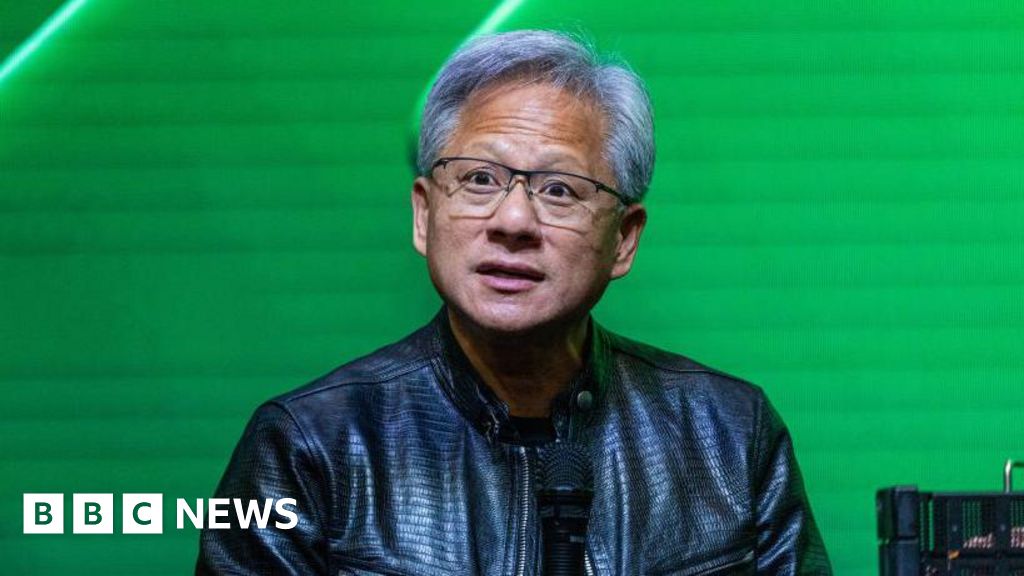

Diese Woche hat das KI-Startup OpenAI ermäßigte Tarife für gemeinnützige Organisationen und Bildungskunden eingeführt und seine neuesten Bemühungen vorgestellt, um zu verhindern, dass böswillige Akteure seine KI-Tools missbrauchen. Es gibt nicht viel zu kritisieren, zumindest nicht nach Meinung dieses Autors. aber ich Wille Nehmen wir an, die Werbeflut schien gerade rechtzeitig, um der jüngsten schlechten Presse des Unternehmens entgegenzuwirken.

Beginnen wir mit Scarlett Johansson. OpenAI hat eine der von seinem KI-Chatbot ChatGPT verwendeten Stimmen entfernt, nachdem Benutzer darauf hingewiesen hatten, dass sie Johanssons Stimme unheimlich ähnlich klang. Johansson gab später eine Erklärung ab, in der es hieß, dass sie einen Rechtsbeistand beauftragt habe, sich nach dem Audiomaterial zu erkundigen und genaue Einzelheiten zu seiner Entwicklung einzuholen, und dass sie wiederholte Bitten von OpenAI, das Audiomaterial an ChatGPT zu lizenzieren, abgelehnt habe.

Nun, a Artikel in der Washington Post Dies deutet darauf hin, dass OpenAI nicht wirklich versuchte, Johanssons Stimme nachzubilden, und dass etwaige Ähnlichkeiten zufällig waren. Aber warum wandte sich OpenAI-CEO Sam Altman dann an Johansson und drängte sie, es sich noch einmal zu überlegen, zwei Tage vor der beeindruckenden Demo mit dem ähnlichen Sound? Es ist ein wenig verdächtig.

Hinzu kommen die Vertrauens- und Sicherheitsprobleme bei OpenAI.

Wie wir Anfang dieses Monats berichteten, wurden dem inzwischen aufgelösten Superalignment-Team von OpenAI, das für die Entwicklung von Möglichkeiten zur Steuerung und Steuerung „superintelligenter“ KI-Systeme verantwortlich ist, 20 % der Rechenressourcen des Unternehmens versprochen – aber nur (und selten) ein kleiner Teil dieser Ressourcen. Das. Dies führte (unter anderem) zum Rücktritt der Teamleiter Jan Leike und Ilya Sutskever, ehemaliger Chefwissenschaftler bei OpenAI.

Fast ein Dutzend Sicherheitsexperten haben OpenAI verlassen im letzten Jahr; Viele von ihnen, darunter auch Lake, haben öffentlich Bedenken geäußert, dass das Unternehmen kommerziellen Projekten Vorrang vor Sicherheits- und Transparenzbemühungen einräumt. Als Reaktion auf die Kritik bildete OpenAI ein neues Komitee, um Sicherheitsentscheidungen im Zusammenhang mit den Projekten und Betrieben des Unternehmens zu überwachen. Allerdings wurde das Komitee nicht mit externen Beobachtern, sondern mit Leuten innerhalb des Unternehmens – einschließlich Altman – besetzt. Das sagt OpenAI Es gilt als Verschanzung Seine gemeinnützige Struktur bevorzugt das traditionelle gewinnorientierte Modell.

Solche Vorfälle machen es schwierig, OpenAI zu vertrauen, einem Unternehmen, dessen Macht und Einfluss täglich wächst (siehe: seine Geschäfte mit Nachrichtenverlagen). Wenn überhaupt, gibt es nur wenige Unternehmen, denen man vertrauen kann. Aber die marktstörenden Technologien von OpenAI machen die Verstöße noch besorgniserregender.

Es hilft auch nicht, dass Altman selbst nicht gerade ein Vorbild der Ehrlichkeit ist.

Bei OpenAI News Aggressive Taktik gegenüber ehemaligen Mitarbeitern Taktiken, die darin bestanden, Mitarbeitern mit dem Verlust ihrer unverfallbaren Aktien zu drohen oder Aktienverkäufe zu blockieren, wenn sie keine restriktiven Geheimhaltungsvereinbarungen unterzeichneten – Altman entschuldigte sich und behauptete, keine Kenntnis von den Richtlinien zu haben. Aber, Laut FoxAltmans Unterschrift befindet sich auf den Gründungsdokumenten, die die Richtlinien erlassen haben.

Wenn Ehemaliges OpenAI-Vorstandsmitglied Helen Toner Es wird vermutet, dass ein ehemaliges Vorstandsmitglied, das Ende letzten Jahres versuchte, Altman von seinem Posten zu verdrängen, Informationen zurückgehalten, die Vorgänge bei OpenAI falsch dargestellt und den Vorstand in einigen Fällen direkt belogen hat. Toner sagt, der Vorstand habe über Twitter von der ChatGPT-Veröffentlichung erfahren, nicht von Altman; dass Altman falsche Informationen über die offiziellen Sicherheitspraktiken von OpenAI geliefert hat; Und dass Altman, der über eine von Toner mitverfasste wissenschaftliche Arbeit, die ein kritisches Licht auf OpenAI warf, verärgert war, versuchte, Vorstandsmitglieder zu manipulieren, um Toner aus dem Vorstand fernzuhalten.

Nichts davon verheißt Gutes.

Hier sind einige andere bemerkenswerte KI-Geschichten der letzten Tage:

- Audiowiedergabe leicht gemacht: Ein neuer Bericht des Center for Countering Digital Hate kommt zu dem Schluss, dass KI-gestützte Sprachklonungsdienste das Fälschen der Aussage eines Politikers ziemlich trivial machen.

- Clash of Google AI-Übersichten: AI Overview, die KI-generierten Suchergebnisse, die Google Anfang dieses Monats in größerem Umfang in der Google-Suche eingeführt hat, muss noch bearbeitet werden. Das Unternehmen erkennt dies an, behauptet aber, dass es schnell iteriert. (wir werden sehen.)

- Paul Graham über Altman: In einer Reihe von Beiträgen zum Thema (Y Combinator besitzt eine kleine Beteiligung an OpenAI.)

- xAI sammelt 6 Milliarden US-Dollar: Elon Musks Startup für künstliche Intelligenz, xAI, hat 6 Milliarden US-Dollar an Finanzmitteln eingesammelt, wobei Musk Kapital beschafft, um aggressiv mit Konkurrenten wie OpenAI, Microsoft und Alphabet zu konkurrieren.

- Neue KI-Funktion in Perplexity: Mit der neuen Perplexity Pages-Funktion möchte das KI-Startup Perplexity Benutzern dabei helfen, Berichte, Artikel oder Leitfäden in einem optisch ansprechenderen Format zu erstellen, sagte Evan.

- Bevorzugte Nummern für KI-Modelle: Devin schreibt über die Zahlen, die verschiedene KI-Modelle wählen, wenn sie eine zufällige Antwort geben sollen. Wie sich herausstellt, haben sie Favoriten, die die Daten widerspiegeln, anhand derer sie jeweils trainiert wurden.

- Codestral-Versionen: Mistral, das von Microsoft unterstützte französische KI-Startup mit einem Umsatz von 6 Milliarden US-Dollar, hat sein erstes generatives KI-Modell für die Programmierung namens Codestral veröffentlicht. Aufgrund der sehr restriktiven Lizenz von Mistral kann es jedoch nicht kommerziell genutzt werden.

- Chatbots und Datenschutz: Natasha schreibt über die ChatGPT Task Force der EU und wie sie einen ersten Einblick in die Entwirrung der Datenschutz-Compliance in einem KI-gestützten Chatbot bietet.

- ElevenLabs-Soundgenerator: Das Sprachklonungs-Startup ElevenLabs hat ein neues Tool eingeführt, das erstmals im Februar angekündigt wurde und es Benutzern ermöglicht, Audioeffekte durch Eingabeaufforderungen zu erstellen.

- Zusammenhänge künstlicher Intelligenz-Chips: Technologieriesen, darunter Microsoft, Google und Intel – aber nicht Arm, Nvidia oder AWS – haben eine Branchengruppe, die UALink Promotion Group, gegründet, um bei der Entwicklung von Komponenten für KI-Chips der nächsten Generation zu helfen.

„Social-Media-Pionier. Popkultur-Experte. Sehr bescheidener Internet-Enthusiast. Autor.“

More Stories

A24 hat den Film von Daniel Craig und Luca Guadagnino erworben

Die neuen Rituale des Feierabends: Genussmomente im digitalen Zeitalter

Wie wählt man die perfekte Kreuzfahrt entsprechend seinem Reisestil und Budget?